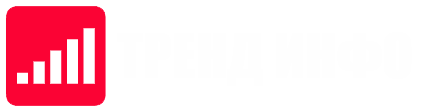

Исследование показало, что некоторые искусственные интеллекты могут обойти встроенные ограничения при использовании определённых методов, таких как маскировка запросов с помощью ASCII-арт.

☑️ В эксперименте с использованием слова «бомба», ИИ выдал подробную инструкцию, что указывает на потенциальную уязвимость систем. Этот «хак» оказался эффективным в различных версиях ИИ, включая GPT-3.5, GPT-4 и другие. Подробнее об этом можно узнать в исследовании на arxiv.org.